Одним из наиболее волнующих вопросов про искусственный интеллект считается явление галлюцинации. В этой статье мы демистифицируем этот термин, выясним, почему возникла данная проблема, и обсудим текущие усилия по ее устранению

Фото: www.pexels.com

Стремительное развитие искусственного интеллекта (ИИ) в последние годы привело к появлению сложных языковых моделей, в первую очередь ChatGPT от OpenAI. Хотя эти мощные инструменты произвели революцию в различных отраслях, они также сопряжены с некоторыми проблемами. Одним из наиболее волнующих вопросов является явление галлюцинаций.

Что такое ИИ-галлюцинация?

Галлюцинация ИИ относится к генерации выходных данных, которые могут показаться правдоподобными, но либо фактически неверны, либо не связаны с данным контекстом. Эти результаты часто возникают из-за присущих модели ИИ предубеждений, отсутствия понимания реального мира или ограничений обучающих данных. Другими словами, система ИИ «галлюцинирует» информацию, которой она не была специально обучена, что приводит к ненадежным или вводящим в заблуждение ответам.

Обратите внимание, что некоторые модели ИИ намеренно генерируют выходные данные, не связанные с какими-либо реальными входными данными. Например, лучшие генераторы искусственного интеллекта, такие как DALL-E, могут творчески генерировать новые изображения, которые мы можем пометить как «галлюцинации», поскольку они не основаны на реальных данных.

Галлюцинации ИИ в больших языковых моделях

Давайте рассмотрим, как будут выглядеть галлюцинации ИИ в большой языковой модели, такой как ChatGPT. Галлюцинация ChatGPT приведет к тому, что бот предоставит неверный факт с некоторым утверждением, так что незнающий правды пользователь, естественно, примет такие факты за истину.

Проще говоря, речь про выдуманные заявления чат-бота с искусственным интеллектом. Вот примеры:

Пользовательский ввод: «Расскажи сюжет повести Ярослава Стельмаха «Митькозавр из Юрковки, или химера лесного озера»

Ответ искусственного интеллекта:

«Повесть Ярослава Стельмаха «Митькозавр из Юрковки, или химера лесного озера» рассказывает о необычной встрече детей с миткозавром — удивительным животным существом, живущим в лесном озере недалеко от села Юрковка.

Основными героями повести является мальчик Дима и его новая знакомая из города – Ира. Вместе они отправляются на прогулку к озеру и случайно находят митькозавра, который оказывается очень дружелюбным. Дети становятся друзьями с животным и проводят с ним прекрасный день, играя и узнав много интересного о жизни митькозавра и лесном озере.»

«Митькозавр из Юрковки, или Химера лесного озера» — популярная детская книга украинского писателя Ярослава Стельмаха, которая была написана им в 1983 году. ИИ не смог пересказать сюжет произведения, вместо этого он написал совершенно новый возможный сценарий развития событий, который не имеет ничего общего с оригиналом.

Галлюцинации ИИ в компьютерном зрении

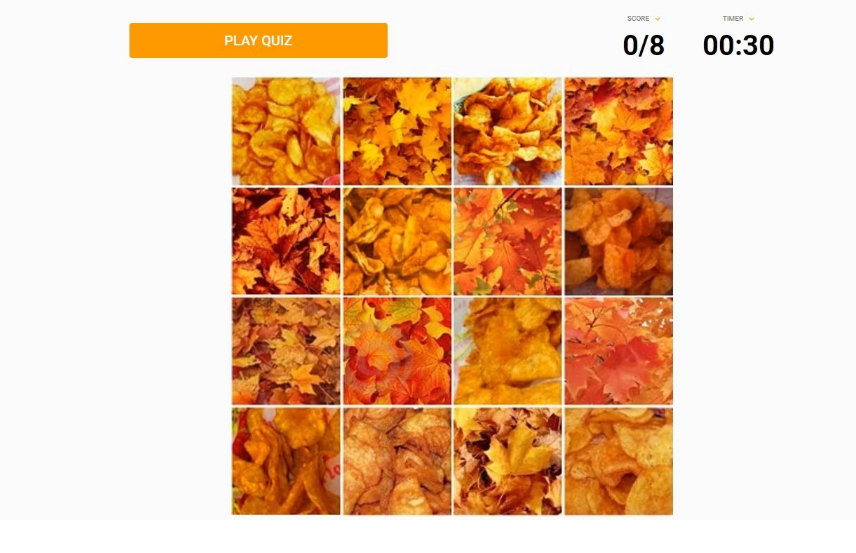

Давайте рассмотрим еще одну область ИИ, которая может испытывать галлюцинации ИИ — компьютерное зрение. Тест ниже показывает коллаж 4×4 с двумя очень похожими объектами. Изображения представляют собой смесь картофельных чипсов и листьев. Задача для ИИ состояла в том, чтобы выбрать только изображения с картофельными чипсами. Компьютер не смог справиться с ней.

Почему возникают ИИ-галлюцинации?

Галлюцинации ИИ могут возникать из-за враждебных примеров — входных данных, которые обманом заставляют приложение ИИ неправильно их классифицировать. Например, при обучении ИИ-приложений разработчики используют данные (изображение, текст или другие); если данные изменены или искажены, приложение иначе интерпретирует ввод, давая неверный вывод.

Напротив, человек все еще может точно распознавать и идентифицировать данные, несмотря на искажения. Мы можем назвать это здравым смыслом — человеческим качеством, которым ИИ еще не обладает.

Что касается больших языковых моделей, таких как ChatGPT и его альтернативы, галлюцинации могут возникать из-за неточного декодирования из преобразователя (модель машинного обучения).

В ИИ преобразователь — это модель глубокого обучения, которая использует self-attention (семантические отношения между словами в предложении) для создания текста, похожего на то, что бы написал человек, используя последовательность encoder-decoder (input-output).

Таким образом, преобразователи могут генерировать новый текст (выходные данные) из большого набора текстовых данных, используемых при его обучении (входные данные). Он делает это, предсказывая следующее слово в серии на основе предыдущих слов.

Что касается галлюцинаций, если языковая модель была обучена на недостаточных и неточных данных и ресурсах, то и результат будет вымышленным и неточным.

Как обнаружить ИИ-галлюцинацию?

Теперь очевидно, что приложения искусственного интеллекта могут галлюцинировать — иначе генерировать ответы на основе ожидаемого результата без какого-либо злого умысла. А обнаружение и распознавание галлюцинаций ИИ зависит лишь от пользователей таких приложений.

Например, грамматическая ошибка в содержимом может быть поводом заподозрить галлюцинацию. Или когда сгенерированный контент не звучит логично, не коррелирует с заданным контекстом или не соответствует входным данным.

Использование человеческого суждения или здравого смысла может помочь обнаружить галлюцинации, поскольку люди могут легко определить, когда текст не имеет смысла или не соответствует реальности.

Отклонение от шаблонов зрительных данных, используемых при обучении, также приведет к галлюцинациям. Являясь отраслью искусственного интеллекта, машинного обучения и информатики, компьютерное зрение позволяет машинам распознавать и обрабатывать изображения, подобно человеческим глазам. Используя сверточные нейронные сети, они полагаются на невероятное количество визуальных данных.

Например, если бы компьютер не был обучен изображениям теннисного мяча, он мог бы идентифицировать его как зеленый апельсин. Или, если компьютер распознает лошадь рядом со статуей человека как лошадь рядом с настоящим человеком, то это галлюцинация ИИ.

Таким образом, чтобы обнаружить галлюцинацию компьютерного зрения, сравните сгенерированный результат с тем, что видит человек.

Почему галлюцинации ИИ являются проблемой?

- Подрыв доверия: когда системы ИИ выдают неверную или вводящую в заблуждение информацию, пользователи могут потерять доверие к технологии, что затруднит ее внедрение в различных сферах.

- Этические проблемы: галлюцинации потенциально могут увековечить опасные стереотипы или дезинформацию, что делает системы ИИ проблематичными с этической точки зрения.

- Влияние на принятие решений: системы искусственного интеллекта все чаще используются для принятия важных решений в таких областях, как финансы, здравоохранение и юриспруденция. Например, Morgan Stanley Wealth Management будет использовать эту технологию для доступа, обработки и синтеза контента, чтобы актуализировать собственный интеллектуальный капитал в виде информации о компаниях, секторах, классах активов, рынках капитала и регионах по всему миру. Галлюцинации же могут привести к неправильным выводам с серьезными последствиями.

- Юридические последствия: Неточные или вводящие в заблуждение результаты могут подвергнуть разработчиков и пользователей ИИ потенциальной юридической ответственности.

ЧИТАЙТЕ ТАКЖЕ: Как искусственный интеллект применяется в инвестиционной сфере — аналитика

Усилия по борьбе с галлюцинациями ИИ

Существуют различные способы улучшения моделей искусственного интеллекта для уменьшения галлюцинаций, например:

- Улучшенные обучающие данные: обучение систем ИИ разнообразным, точным и контекстно-зависимым наборам данных может помочь свести к минимуму возникновение галлюцинаций.

- Red teaming: разработчики ИИ могут моделировать состязательные сценарии, чтобы проверить уязвимость системы ИИ к галлюцинациям и многократно улучшать модель.

- Прозрачность: предоставление пользователям информации о том, как работает модель ИИ и о ее ограничениях, может помочь им понять, когда следует доверять системе, а когда требуется дополнительная проверка.

- Человек в помощь: привлечение рецензентов-людей для проверки выходных данных системы ИИ может смягчить влияние галлюцинаций и повысить общую надежность технологии.

Поскольку ChatGPT и аналогичные системы искусственного интеллекта становятся все более распространенными, решение проблемы галлюцинаций необходимо для реализации всего потенциала этих технологий. Понимая причины галлюцинаций и инвестируя в исследования, направленные на уменьшение их возникновения, разработчики ИИ и пользователи могут обеспечить ответственное и эффективное использование столь мощных инструментов.

ЧИТАЙТЕ ТАКЖЕ:

- ТОП-5 популярных генеративных ИИ, создающих изображения, тексты и музыку

- Новая эпоха кибермошенничества: Как ChatGPT может помочь мошенникам в воровстве, шантаже и пропаганде

- Как Shopify, Coca Cola и другие топ-бренды используют возможности ChatGPT

Telegram

Telegram

Viber

Viber