Одним із найбільш хвилюючих питань про штучний інтелект вважається явище галюцинації. У цій статті ми демістифікуємо цей термін, з’ясуємо, чому виникла така проблема, та обговоримо поточні зусилля щодо її усунення

Фото: www.pexels.com

Стрімкий розвиток штучного інтелекту (ШІ) в останні роки призвів до появи складних мовних моделей, насамперед ChatGPT від OpenAI. Хоча ці потужні інструменти зробили революцію у різних галузях, вони також пов’язані з деякими проблемами. Одним із найбільш хвилюючих питань є явище галюцинацій.

Що таке ШІ-галюцинація?

Галюцинація ШІ належить до генерації вихідних даних, які можуть здатися правдоподібними, але фактично неправильні, або не пов’язані з даним контекстом. Ці результати часто виникають через властиві моделі ШІ упередження, відсутність розуміння реального світу або обмеження навчальних даних. Іншими словами, система ШІ «галюцинує» інформацію, якою вона не була спеціально навчена, що призводить до ненадійних або в вводячих в оману відповідей.

Зверніть увагу, що деякі моделі ШІ навмисно генерують вихідні дані, які не пов’язані з будь-якими реальними вхідними даними. Наприклад, найкращі генератори штучного інтелекту, такі як DALL-E, можуть творчо генерувати нові зображення, які ми можемо позначити як галюцинації, оскільки вони не засновані на реальних даних.

Галюцинації ШІ у великих мовних моделях

Розгляньмо як виглядатимуть галюцинації ШІ у великій мовній моделі ChatGPT. Галюцинація ChatGPT призведе до того, що бот надасть невірний факт з деяким твердженням, так що користувач, який не знає правди, природно, прийме такі факти за істину.

Простіше кажучи, мова про вигадані заяви чат-бота зі штучним інтелектом. Ось приклади:

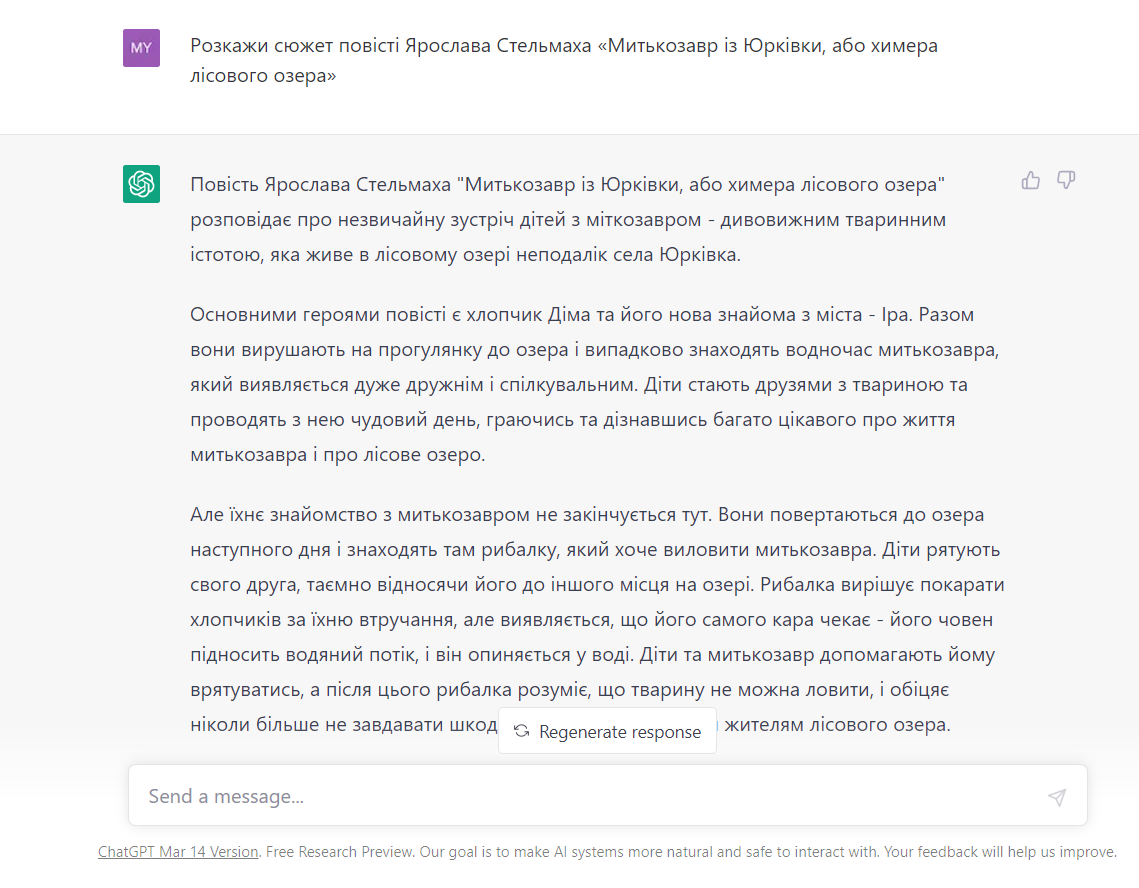

Запит користувача: «Розкажи сюжет повісті Ярослава Стельмаха «Митькозавр з Юрківки, або химера лісового озера»

Відповідь штучного інтелекту:

«Митькозавр із Юрківки, або Хімера лісового озера» — популярна дитяча книга українського письменника Ярослава Стельмаха, написана ним 1983 року, яка входить до шкільної програми 6 класу. ШІ не зміг переказати сюжет твору, натомість він написав зовсім новий можливий сценарій розвитку подій, який не має нічого спільного з оригіналом.

Галюцинації ШІ у комп’ютерному зорі

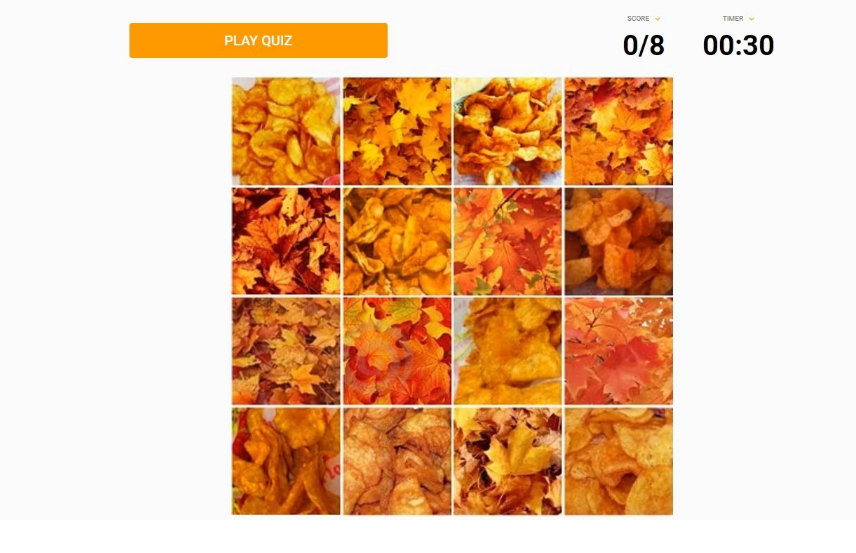

Поговоримо про ще одну область ШІ, яка може відчувати галюцинації ШІ — комп’ютерний зір. Тест нижче показує колаж 4×4 із двома дуже схожими об’єктами. Зображення є сумішшю картопляних чипсів і листя. Завдання для ШІ полягало в тому, щоб вибрати лише зображення з картопляними чипсами. Комп’ютер не зміг упоратися з нею.

Чому виникають ШІ-галюцинації?

Галюцинації ШІ можуть виникати через ворожі приклади — вхідні дані, які обманом змушують додаток ШІ неправильно їх класифікувати. Наприклад, під час навчання ШІ-додатків розробники використовують дані (зображення, текст чи інші); якщо дані змінені або спотворені, програма інакше інтерпретує введення, даючи неправильний висновок.

Навпаки, людина все ще може точно розпізнавати та ідентифікувати дані, попри спотворення. Ми можемо назвати це здоровим глуздом — людською якістю, якою ШІ ще не має.

Що стосується великих мовних моделей, таких як ChatGPT та його альтернативи, галюцинації можуть виникати через неточне декодування з перетворювача (модель машинного навчання).

В ШІ перетворювач — це модель глибокого навчання, яка використовує self-attention (семантичні відносини між словами в реченні) для створення тексту, схожого на те, що написала б людина, використовуючи послідовність encoder-decoder (input-output).

Таким чином, перетворювачі можуть генерувати новий текст (вихідні дані) з великого набору текстових даних, що використовуються під час навчання (вхідні дані). Він робить це, пророкуючи наступне слово в серії на основі попередніх слів.

Що стосується галюцинацій, якщо мовна модель була навчена на недостатніх і неточних даних і ресурсах, то результат буде вигаданим і неточним.

Як виявити ШІ-галюцинацію?

Тепер очевидно, що застосунки штучного інтелекту можуть галюцинувати — інакше генерувати відповіді на основі очікуваного результату без будь-якого злого наміру. А виявлення та розпізнавання галюцинацій ШІ залежить лише від користувачів таких додатків.

Наприклад, граматична помилка у вмісті може бути приводом запідозрити галюцинацію. Або коли згенерований контент не звучить логічно, не корелює із заданим контекстом або не відповідає вхідним даним. Використання людської думки або здорового глузду може допомогти виявити галюцинації, оскільки люди можуть легко визначити, коли текст не має сенсу або не відповідає реальності.

Відхилення від шаблонів зорових даних, що використовуються під час навчання, також призведе до галюцинацій. Бувши галуззю штучного інтелекту, машинного навчання та інформатики, комп’ютерний зір дозволяє машинам розпізнавати та обробляти зображення, подібно до людських очей. Використовуючи згорткові нейронні мережі, вони покладаються на неймовірну кількість візуальних даних.

Наприклад, якби комп’ютер не був навчений зображенням тенісного м’яча, він міг би його ідентифікувати як зелений апельсин. Або, якщо комп’ютер розпізнає коня поруч зі статуєю людини як коня поруч зі справжньою людиною, це галюцинація ШІ.

Таким чином, щоб виявити галюцинацію комп’ютерного зору, порівняйте згенерований результат із тим, що бачить людина.

Чому галюцинації ШІ є проблемою?

- Підрив довіри: коли системи ШІ видають неправильну інформацію, яка вводить в оману, користувачі можуть втратити довіру до технології, що ускладнить її впровадження в різних сферах.

- Етичні проблеми: галюцинації потенційно можуть увічнити небезпечні стереотипи або дезінформацію, що робить ШІ проблематичним з етичної точки зору.

- Вплив на прийняття рішень: системи штучного інтелекту все частіше використовуються для прийняття важливих рішень у таких галузях, як фінанси, охорона здоров’я та юриспруденція. Наприклад, Morgan Stanley Wealth Management буде використовувати цю технологію для обробки та синтезу контенту, щоб актуалізувати власний інтелектуальний капітал у вигляді інформації про компанії, сектори, класи активів, ринки капіталу та регіони по всьому світу. Галюцинації можуть призвести до неправильних висновків з серйозними наслідками.

- Юридичні наслідки: Неточні результати, що вводять в оману, можуть піддати розробників і користувачів ШІ потенційної юридичної відповідальності.

ЧИТАЙТЕ ТАКОЖ: Як штучний інтелект застосовується в інвестиційній сфері — аналітика

Зусилля в боротьбі з галюцинаціями ШІ

Існують різні способи покращення моделей штучного інтелекту для зменшення галюцинацій, наприклад:

- Поліпшені навчальні дані: навчання систем ШІ різноманітним, точним та контекстно-залежним наборам даних може допомогти звести до мінімуму виникнення галюцинацій.

- Red teaming: розробники ШІ можуть моделювати змагальні сценарії, щоб перевірити вразливість системи ШІ до галюцинацій та багаторазово покращувати модель.

- Прозорість: надання користувачам інформації про те, як працює модель ШІ та про її обмеження, може допомогти їм зрозуміти, коли слід довіряти системі, а коли потрібна додаткова перевірка.

- Людина на допомогу: залучення рецензентів-людей для перевірки вихідних даних системи ШІ може пом’якшити вплив галюцинацій та підвищити загальну надійність технології.

Оскільки ChatGPT і аналогічні системи штучного інтелекту стають все більш поширеними, розв’язання проблеми галюцинацій необхідне для реалізації всього потенціалу цих технологій. Розуміючи причини галюцинацій та інвестуючи в дослідження, спрямовані на зменшення їх виникнення, розробники ШІ та користувачі можуть забезпечити відповідальне та ефективне використання таких потужних інструментів.

ЧИТАЙТЕ ТАКОЖ:

- ТОП-5 популярних генеративних ШІ, що створюють зображення, тексти та музику

- Нова епоха кібершахрайства: Як ChatGPT може допомогти шахраям у крадіжках, шантажі та пропаганді

- Як Shopify, Coca Cola та інші топ-бренди використовують можливості ChatGPT

Telegram

Telegram

Viber

Viber